ELK中各个服务的作用

Elasticsearch:用于存储收集到的日志信息;

Logstash:用于收集日志,SpringBoot应用整合了Logstash以后会把日志发送给Logstash,Logstash再把日志转发给Elasticsearch;

Kibana:通过Web端的可视化界面来查看日志。

使用Docker Compose 搭建ELK环境

注意:elk 的各个软件版本一定要一致,否则可能会导致服务异常。

我们以7.6.2 版本为例(低版本配置中文需要插件,高版本秩序设置 i18n参数)

docker pull elasticsearch:7.6.2 docker pull logstash:7.6.2 docker pull kibana:7.6.2

创建elasticsearch 相关目录

创建相关目录,注意data目录需要设置权限,否则elasticsearch会因为无权限访问而启动失败

mkdir -p /mysoft/elk/elasticsearch/data/ chmod -R 777 /mysoft/elk/elasticsearch/data/

创建一个存放logstash配置的目录(logstash-springboot.conf)并编写配置文件

mkdir -p /mysoft/elk/logstash

input {

tcp {

mode => "server"

host => "0.0.0.0"

port => 9205

codec => json_lines

}

}

output {

elasticsearch {

hosts => "es:9200"

index => "springboot-logstash-%{+YYYY.MM.dd}"

}

}

docker-compose 配置启动 ELK环境

编写 docker-compose 文件

version: '3'

services:

elasticsearch:

image: elasticsearch:7.6.2

container_name: elasticsearch

environment:

- "cluster.name=elasticsearch" #设置集群名称为elasticsearch

- "discovery.type=single-node" #以单一节点模式启动

- "ES_JAVA_OPTS=-Xms512m -Xmx512m" #设置使用jvm内存大小

volumes:

- /mysoft/elk/elasticsearch/plugins:/usr/share/elasticsearch/plugins #插件文件挂载

- /mysoft/elk/elasticsearch/data:/usr/share/elasticsearch/data #数据文件挂载

ports:

- 9200:9200

kibana:

image: kibana:7.6.2

container_name: kibana

links:

- elasticsearch:es #可以用es这个域名访问elasticsearch服务

depends_on:

- elasticsearch #kibana在elasticsearch启动之后再启动

environment:

- "elasticsearch.hosts=http://es:9200" #设置访问elasticsearch的地址

ports:

- 5601:5601

logstash:

image: logstash:7.6.2

container_name: logstash

volumes:

- /mysoft/elk/logstash/logstash-springboot.conf:/usr/share/logstash/pipeline/logstash.conf #挂载logstash的配置文件

depends_on:

- elasticsearch #kibana在elasticsearch启动之后再启动

links:

- elasticsearch:es #可以用es这个域名访问elasticsearch服务

ports:

- 9205:9205

启动相关环境:

docker-compose up -d

如果需要调整logstash 内存,需要变更 容器内的配置文件/usr/share/logstash/config/vm.options,将内存参数调至你合适的内存即可

在logstash中安装json_lines插件

# 进入logstash容器 docker exec -it logstash /bin/bash # 进入bin目录 cd /bin/ # 安装插件 logstash-plugin install logstash-codec-json_lines # 退出容器 exit # 重启logstash服务 docker restart logstash

配置kibana 中文

docker exec -it kibana /bin/bash cd /usr/share/kibana/config vi kibana.yml # 在最后增加如下参数,注意空格 i18n.locale: "zh-CN" exit docker restart kibana

访问 localhost:5601 即可看到 kibana

spingboot 集成 logstash

配置 logstash 依赖

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>net.logstash.logback</groupId>

<artifactId>logstash-logback-encoder</artifactId>

<version>5.1</version>

</dependency>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<optional>true</optional>

</dependency>

编写 logback.xml 配置。下面只贴主要配置:

<appender name="LOGSTASH" class="net.logstash.logback.appender.LogstashTcpSocketAppender">

<destination>localhost:9205</destination>

<queueSize>1048576</queueSize>

<encoder charset="UTF-8" class="net.logstash.logback.encoder.LogstashEncoder" />

</appender>

<root level="info">

<appender-ref ref="LOGSTASH"/>

</root>

程序 yml 配置

logging: config: classpath:logback-spring.xml

然后编写个接口测试下

@RestController

@Slf4j

public class HelloController {

@RequestMapping("/sayHi/{name}")

public String sayHi(@PathVariable("name") String name){

log.info("hello"+name);

return "hello"+name;

}

}

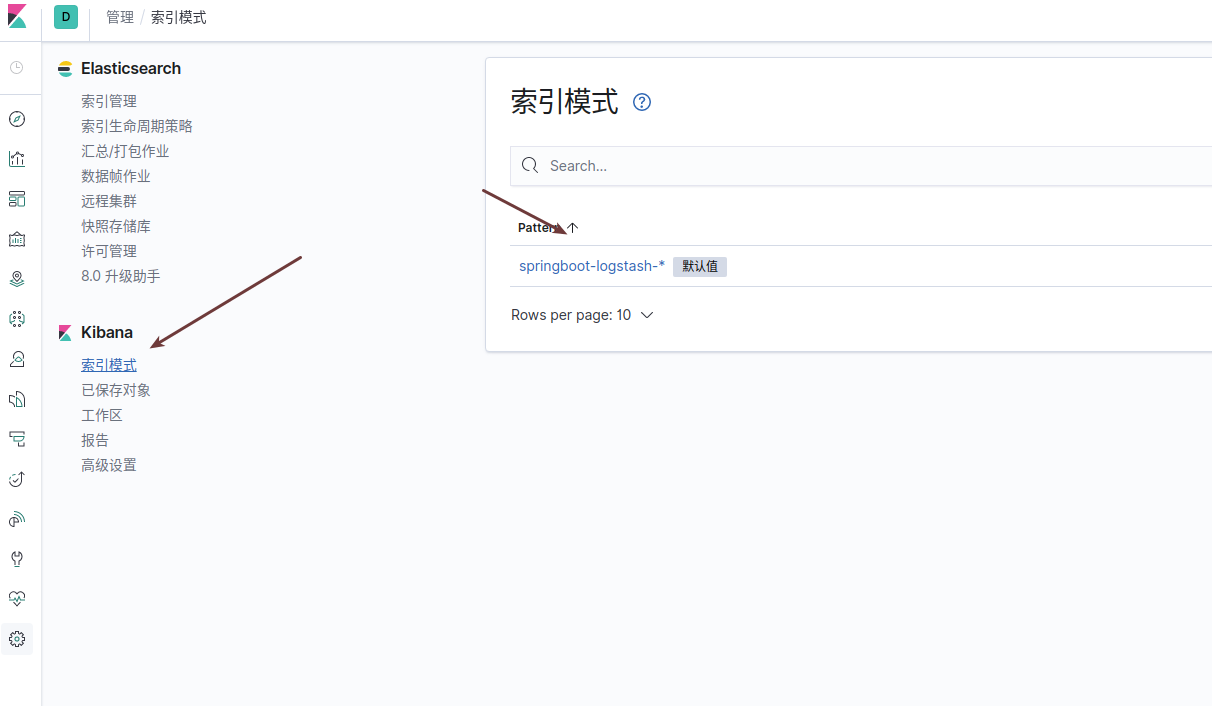

访问 kibana 控制台,设置索引,如下图

然后点击发现,搜索就能看到我们的日志了,如下图